3대 전략 , 10대 전략 실천 과제 제시

'개발 가이드북' 제작·보급 및 민간 자율 '인증제' 도입·지원

설명가능성·공정성·견고성 등 위한 신뢰성 원천 기술 개발

윤리 교육 강화...개발자 및 이용자용 체크리스트 보급

과학기술정보통신부(이하 과기정통부)는 13일 제 22차 4차산업혁명위원회 전체회의에서 사람이 중심이 되는 인공지능을 위한 '신뢰할 수 인공지능 실현 전략'을 발표했다.

인공지능(AI)이 산업 사회 전반에 빠르게 확산됨에 따라 국내 인공지능 챗봇 이루다(21.1) 사례를 포함, 미 오바마 전대통령 딥페이크(18.7), MIT개발 사이코패스 AI(18.6) 등 예상치 못한 사회적 이슈가 발생, AI에 대한 우려의 목소리가 나왔다.

이에 정부는 누구나 신뢰할 수 있는 AI, 모두가 누릴 수 있는 AI 구현을 토대로 '인공지능 강국'으로 도약하고자 이 같은 지원 정책이 조속히 필요하다고 판단, 전략을 마련하게 됐다.

지난해 12월 발표한 '인공지능 윤리기준'의 실천방안을 구체화한 이번 전략은 책임있는 인공지능 활용국 세계 5위, 신뢰 있는 사회 구축국 세계 10위, 안전한 사이버국가 세계 3위를 목표로 3대 전략과 10대 실행과제를 통해 2025년 까지 단계적으로 추진할 계획이다.

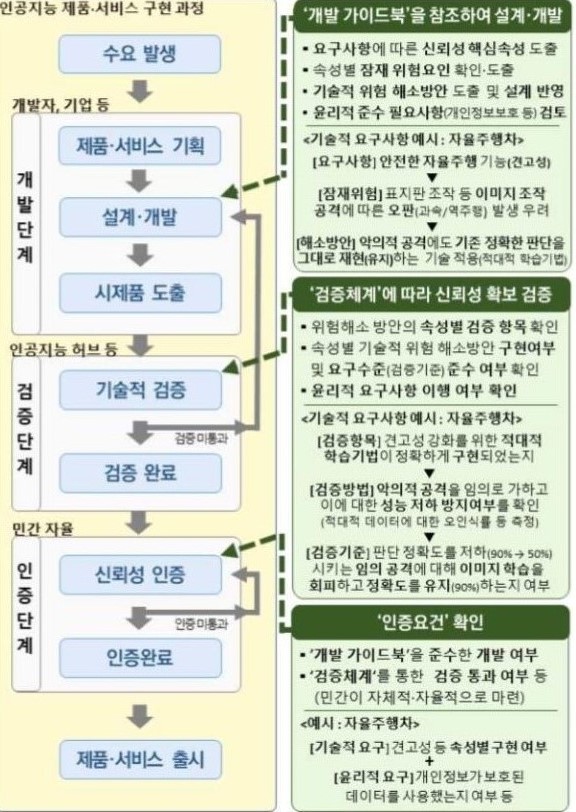

신뢰 확보체계를 마련하는 차원에서 우선 AI 제품·서비스 구현 단계별로 신뢰 확보 체계 마련한 '개발 가이드북'을 제작 및 보급해 검증 단계에서 확인한다. 데이터확보→알고리즘 학습→검증을 통합 지원하는 인공지능 허브 플랫폼을 운영해 평가할 수 있는 검증 체계도 마련한다.

인증 단계에서 기술·윤리적 요구사항을 충족, 이를 통과한 제품·서비스에 대해 민간 자율 인증과 공시를 추진할 계획이다.

또한, 이미 구현된 시스템에 대해서 AI의 편향성에 대해 진단하고, 문제 요소를 효율적으로 제거할 수 있는 원천기술 개발을 추진한다.

이에 인공지능의 설명가능성, 공정성, 견고성 제고를 위해 2022년부터 2026년까지 총 5년의 기간 동안 설명가능성, 공정성 기술 분야 개발에 각각 450억원과 200억원을 지원할 예정이다. 견고성 분야 기술 개발은 아직 미확정 상태다.

안전한 AI 활용 기반을 마련하기 위해 AI 학습용 데이터의 신뢰성을 제고하며, 고위험군 AI에 대한 신뢰 확보도 제도화를 추진한다.

특히 지난해 발굴된 과제인, 업계 내 자율적 알고리즘 관리 및 감독 환경 조성, 플랫폼 알고리즘 공정성 및 투명성 확보, 영업비밀 보장 위한 알고리즘 공개기준, 고위험군 기술기준 마련 등에 관한 제도도 개선할 계획이다.

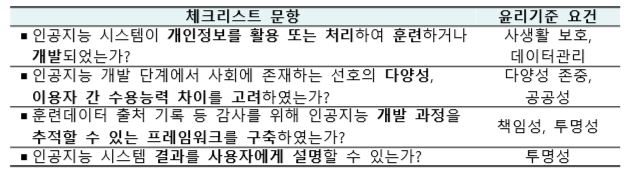

또한, AI에 대한 윤리 교육를 강화하고 AI가 사회에 미치는 영향에 대해 주체별 체크리스트를 마련, 배포해 평가를 실시한다. 학계, 기업, 시민단체 등이 참가하는 윤리 정책 플랫폼도 운영할 계획이다.

AI타임스 이하나 기자 22hnxa@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com