모델이 스스로 학습...라벨데이터 적어도 돼

지식 증류 방식(DISTL)모델 적용한 알고리즘

비효율적인 의료 이미지 라벨 수집, 극복 가능성

서울대병원, 서울아산병원, 경북대병원 등 연구 참여

흉부 엑스선 영상 판독 능력치를 자동으로 올리는 인공지능(AI) 알고리즘이 나왔다. 적은 라벨데이터로 초기 모델을 학습해 주면 스스로 판독 성능을 키운다. 시간이 지나며 쌓이는 라벨 없는 데이터 자체만을 가지고 학습해서다. 의료 이미지 라벨 수집에 걸림돌이던 비용문제를 완화할 수 있을 전망이다.

카이스트(총장 이광형, KAIST)가 결핵, 기흉, 코로나-19 등의 흉부 엑스선 영상을 이용한 폐 질환 자동 판독 능력을 스스로 향상할 수 있는 ‘자기 진화형 AI’ 기술을 개발했다고 27일 밝혔다. 예종철 김재철AI대학원 교수 연구팀이 만들었다. 서울대병원, 서울아산병원, 충남대병원, 영남대병원, 경북대병원도 개발에 참여했다.

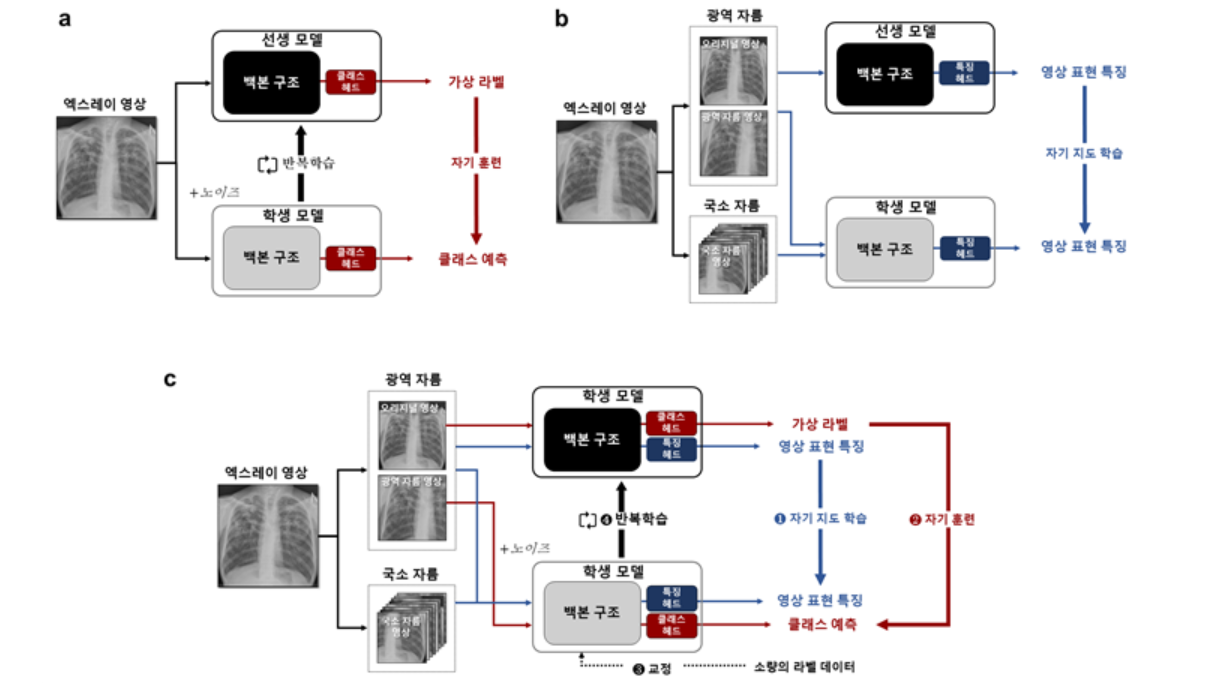

이번 알고리즘은 '자기 훈련 방식 (Self-supervised learning)'과 '자기 지도 학습법(Self-train learning)'을 합친 '지식 증류 (DISTL, Distillation for elf-supervised and self-train learning)' 모델이다.

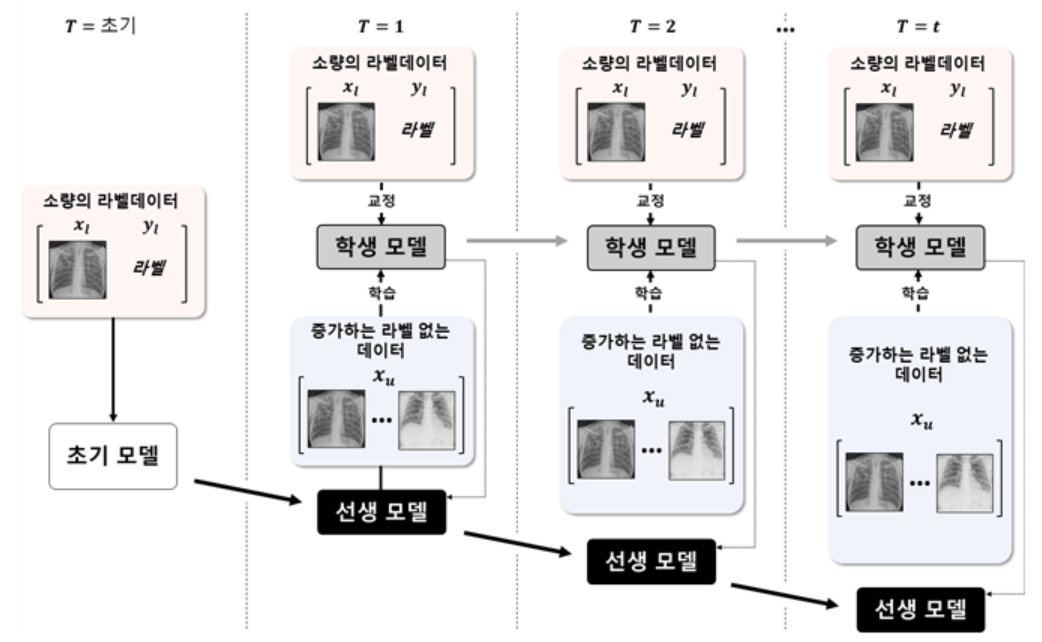

자기 훈련 방식은 적은 라벨데이터를 가지고 선생 모델을 학습한 후 선생 모델이 내놓은 예측값을 학생 모델이 따라가는 방식이다.

자기 지도 학습 기법도 마찬가지다. 선생-학생 지식 증류 방식을 기반으로 한다. 영상을 크게 잘라낸 부분과 작게 잘라낸 부분이 서로 같은 영상이라는 것을 학습하는 방식인 ‘전체-일부 일치 학습’을 통해 진행한다. 작업과 무관한 영상 구조 정보를 학습하기 위해서다.

또 학생 모델이 선생 모델의 잘못된 예측값으로부터 성능이 떨어지는 것을 방지한다. 특정 단계마다 처음 선생 모델을 학습시킬 때 사용한 라벨 데이터를 활용해 교정 작업을 수행한다.

이번 연구에서는 DISTL 프레임워크를 결핵, 기흉, 코로나-19 진단에 적용했다. 라벨 데이터도 소수만 입력했다. 결과적으로 라벨 없는 데이터 자체가 쌓여감에 따라 모델이 점차적으로 스스로 성능을 높일 수 있었다.

영상 획득 과정에서 무관한 데이터나 잘못 라벨링 된 노이즈가 섞이는 현상을 불가피하다. 그러나 이와 무관하게 성능을 유지할 수 있다는 결과도 검증됐다. 노이즈 추가 여부에 관계없이 AI 모델이 안정적으로 성능을 향상할 수 있다는 점도 증명한 셈이다.

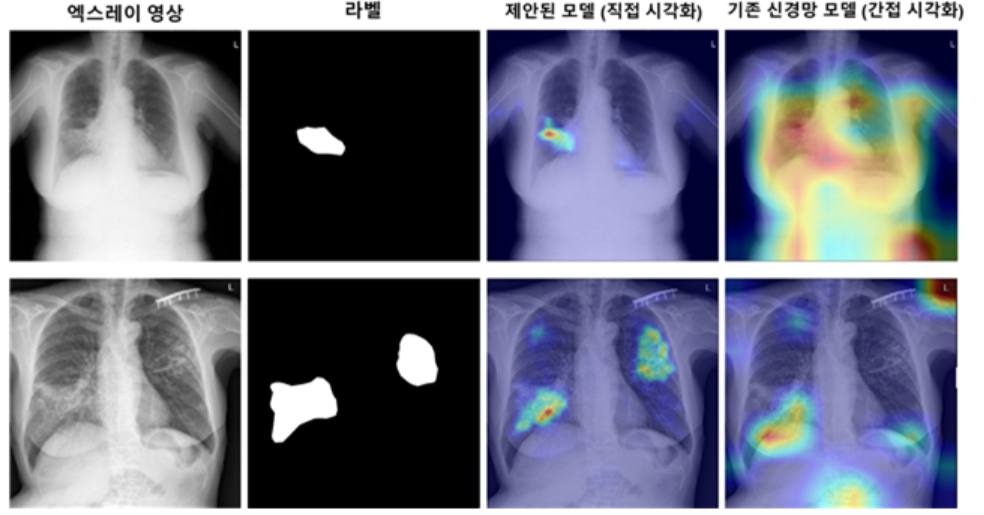

연구진은 비전 변환기 모델의 자기 집중 결과물(Self-attention output)을 분석해, DISTL을 활용함으로써 모델이 성능을 끌어올릴 때마다 변환기 모듈의 집중 결과물도 점차 개선돼 나간 것도 검증했다.

"비효율적인 대량 라벨 생성 비용, 줄일 수 있어"

현재 사용되는 대부분 AI 기법은 지도학습 방식(Superised-learning)으로 이뤄졌다. AI 모델이 학습하려면 전문가에 의한 다량의 라벨이 필수다. 그러나 실제로 임상 현장에서 제대로 라벨링 된 대규모 데이터를 지속적으로 얻는 건 비효율적이다. 비용과 시간이 많이 들어서다. 영상 전문의 인력 부족도 걸림돌이다.

예종철 교수는 “DISTL 모델은 AI 학습을 위한 레이블 생성 비용을 줄이면서도 지도학습 성능을 뛰어넘었다”며 “전문가가 라벨을 지속적으로 수집하고 비 지도학습 방식으로는 성능이 낮았던 기존 문제점을 극복해 의미있다”고 전했다.

박사과정 재학중인 박상준씨가 제1 저자로 참여한 이번 연구 결과는 국제 학술지 '네이처 커뮤니케이션스(Nature Communications)'에 이달 4일 게재됐다. 논문명은 'Self-evolving vision transformer for chest X-ray diagnosis through knowledge distillation'다.

이번 연구는 중견연구자지원사업, 범부처전주기의료기기연구개발사업, 한국과학기술원 중점연구소 사업 등의 지원으로 수행됐다.

AI타임스 김미정 기자 kimj7521@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com